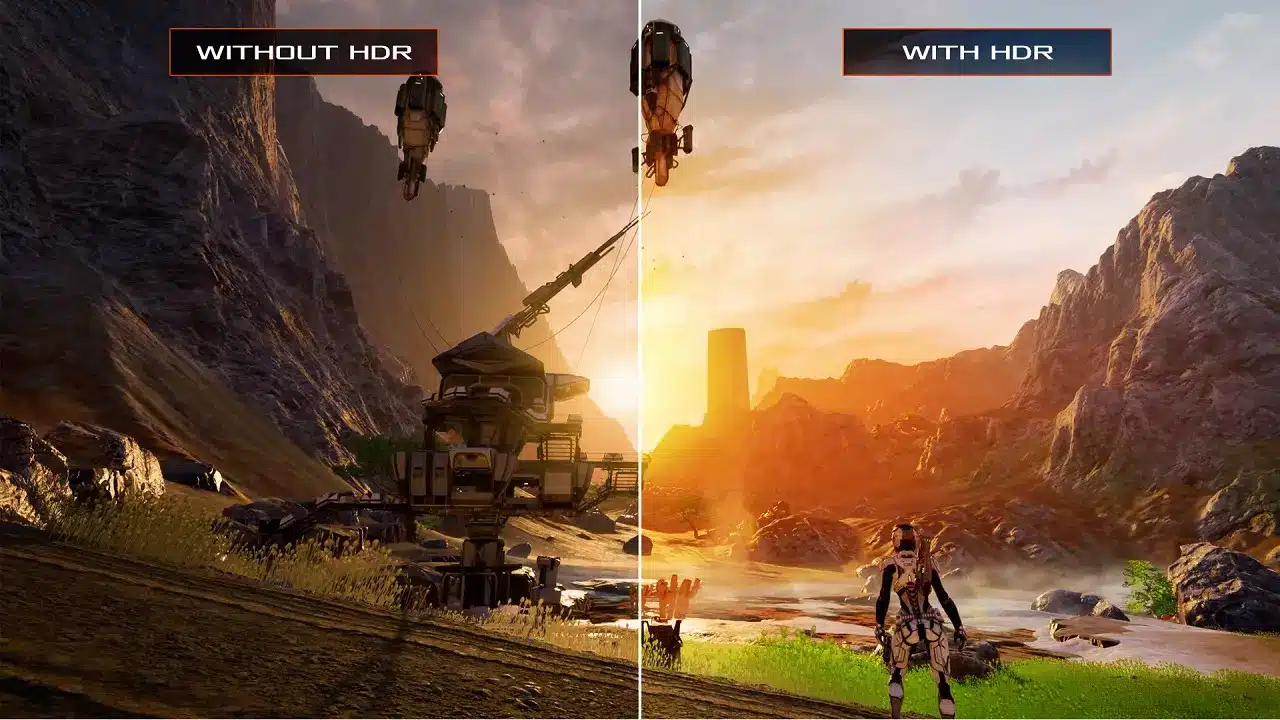

L’arrivo dell’HDR nei videogiochi ha rappresentato un cambiamento radicale in termini di qualità visiva.

Il suo impatto sulla resa complessiva è di gran lunga superiore a quello dell’aumento di risoluzione, in quanto coinvolge la quantità di colori visualizzabili e i livelli di luminosità. Un miglioramento generale e tangibile, che per altro non ha praticamente nessuna ripercussione sulle prestazioni.

Tuttavia mostra il fianco a una criticità, ovvero la sua dipendenza dall’elettronica dei display. I risultati variano infatti in base al TV o al monitor che stiamo utilizzando.

Nella guida di oggi cercheremo di spiegarvi come funziona l’HDR nei videogiochi, semplificando i concetti ai minimi termini per far sì che siano comprensibili per chiunque.

Indice

HDR nei videogiochi: cos’è?

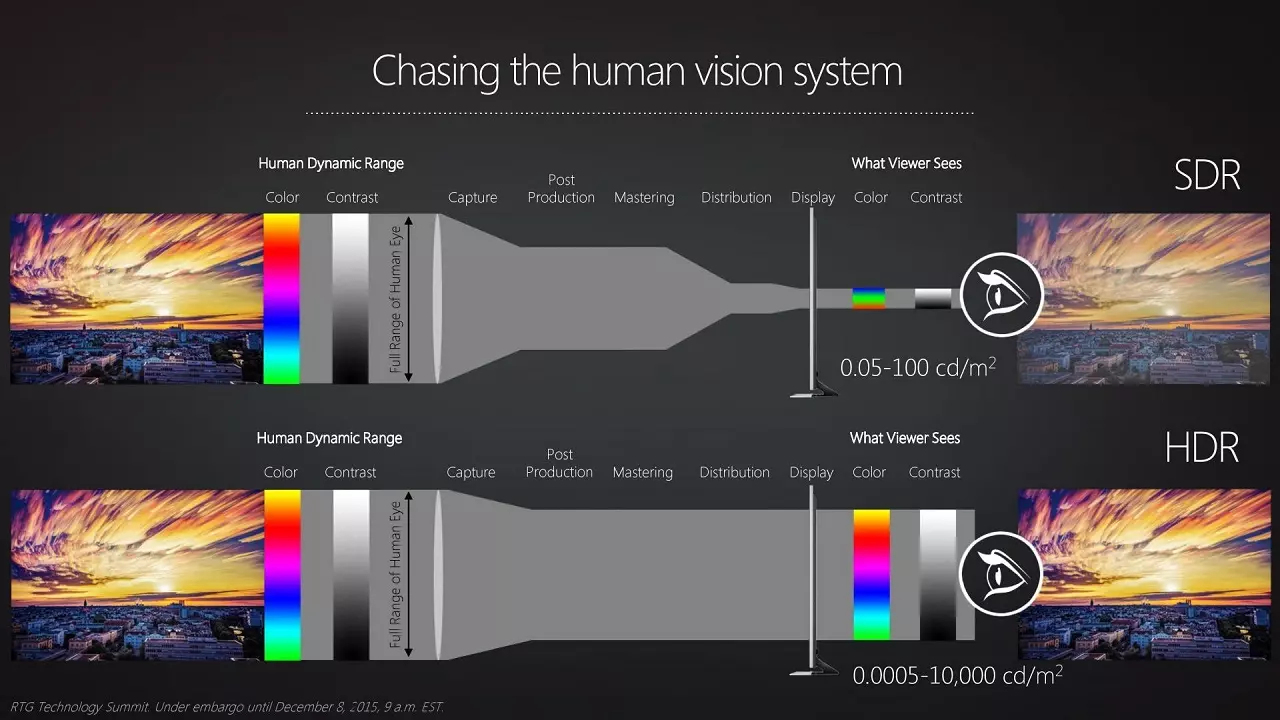

HDR è un acronimo e sta per High Dynamic Range, che tradotto significa alta gamma dinamica. Si contrappone al formato SDR, ovvero Standard Dynamic Range, quello che abbiamo usato per anni.

L’HDR è stato introdotto nel settore dell’elettronica di consumo praticamente insieme allo standard UHD 4K e ne rappresenta ormai anche un requisito di certificazione, sebbene si possa trovare anche su display con risoluzioni diverse e in settore differenti, tipo i monitor da gaming.

Come funziona l’HDR nei videogiochi

Non dovete fare l’errore di ridurre l’HDR alla sola luminosità massima raggiungibile, non si tratta solo di questo.

Se da una parte è vero che uno dei tratti distintivi di un buon HDR è proprio il picco di luminosità raggiunto ed espresso in nits, molto più significativo è ciò riguarda nello specifico la parola Range.

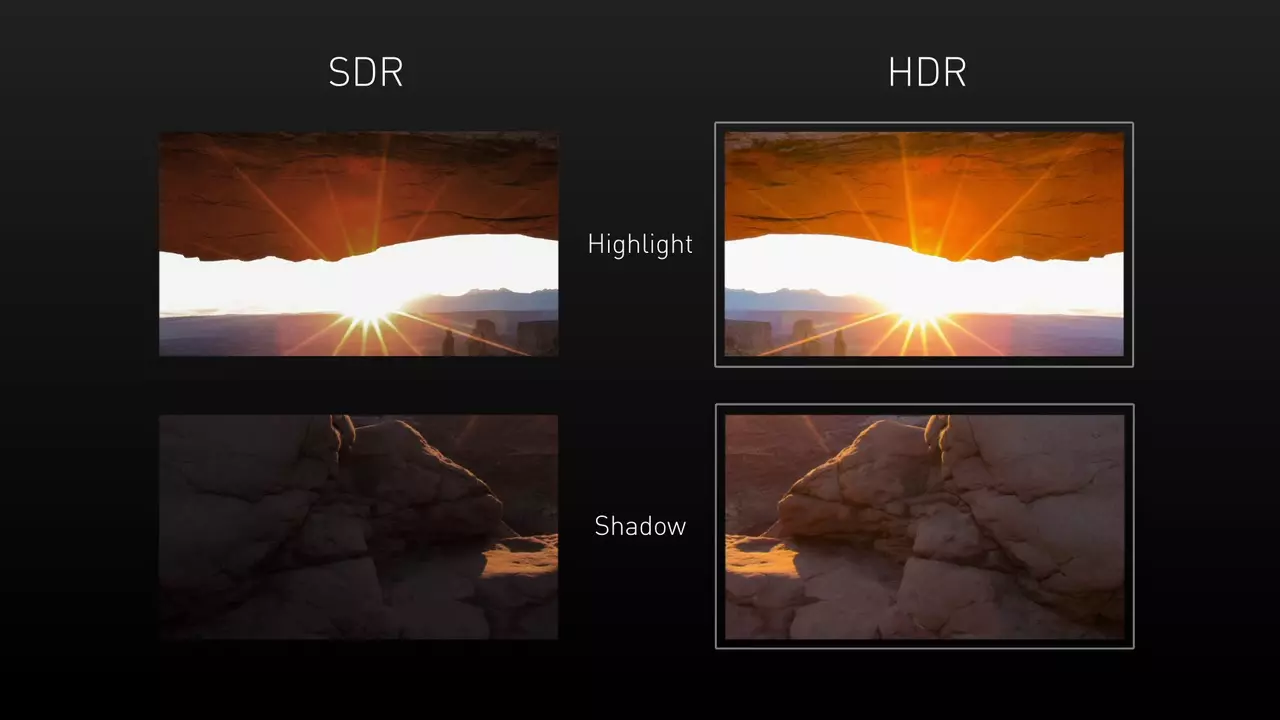

Cerchiamo di spiegarlo in modo semplice: a parità di picco massimo il display HDR riesce a riprodurre più dettagli visibili sia nei punti più scuri che nei punti più chiari, coprendo una maggiore stratificazione delle sfumature di luminosità e soprattutto di colore.

Un buon pannello HDR, magari di fascia alta, abbina a questa migliore copertura anche picchi di luminosità irraggiungibili per i display SDR, come i 1000 o anche i 2000 nits.

L’importanza dell’HDR nei videogiochi

L’obiettivo di questa tecnologia è di visualizzare un ampio spettro di sfumature di colore e di luce. Un range, appunto, molto più fedele alla realtà rispetto ai limiti del vecchio SDR.

Un buon HDR setta quindi un netto passo avanti nel campo del cinema o della fotografia, ma trova la sua utilità anche nel settore del gaming, dove non per forza l’estetica di un gioco punta al fotorealismo.

L’HDR nei videogiochi migliora la resa complessiva a prescindere, anche e soprattutto nei giochi più colorati e saturi, a fronte di un significativo boost in termini di copertura dei colori e potenziali sfumature.

A seconda poi di come viene implementato nel singolo gioco, perfino gli shaders addetti a simulare le varie superfici possono risultare più realistici e gradevoli alla vista. Un buon HDR è quindi un passo avanti anche più ampio di quello offerto dalla risoluzione.

HDR nei videogiochi: un cenno di storia

L’HDR nei videogiochi esiste da molto tempo se si parla di rendering ma ripercorrerne l’intera storia implica addentrarci in soporifere spiegazioni tecniche, che conviene lasciare ai margini.

Vi basti sapere che negli ambienti di sviluppo non si tratta di una novità. Ciò nonostante non è mai stato possibile visualizzare i videogiochi in alta gamma dinamica, perché i display in commercio non ne erano capaci.

Gli sviluppatori, di conseguenza, adattavano il loro software agli hardware di riferimento e l’output si riduceva al semplice SDR. Quando poi i televisori e i monitor hanno adottato questa tecnologia, anche le console e i sistemi operativi si sono adeguati di conseguenza.

Le prime console con HDR

PlayStation 4 e Xbox One uscite nel 2013 non erano compatibili con l’HDR. Solo più tardi, con il lancio di nuove versioni delle due console, i produttori hardware hanno aggiunto la funzione HDR nei videogiochi.

La PlayStation 4 Standard è stata aggiornata via firmware per simularne l’utilizzo. PS4 Pro invece poteva gestirlo nativamente, così come ovviamente l’attuale PlayStation 5. Se vi serve una guida per attivare l’HDR sulle console Sony vi consigliamo di leggere i nostri articoli specifici per PS4 e PS5.

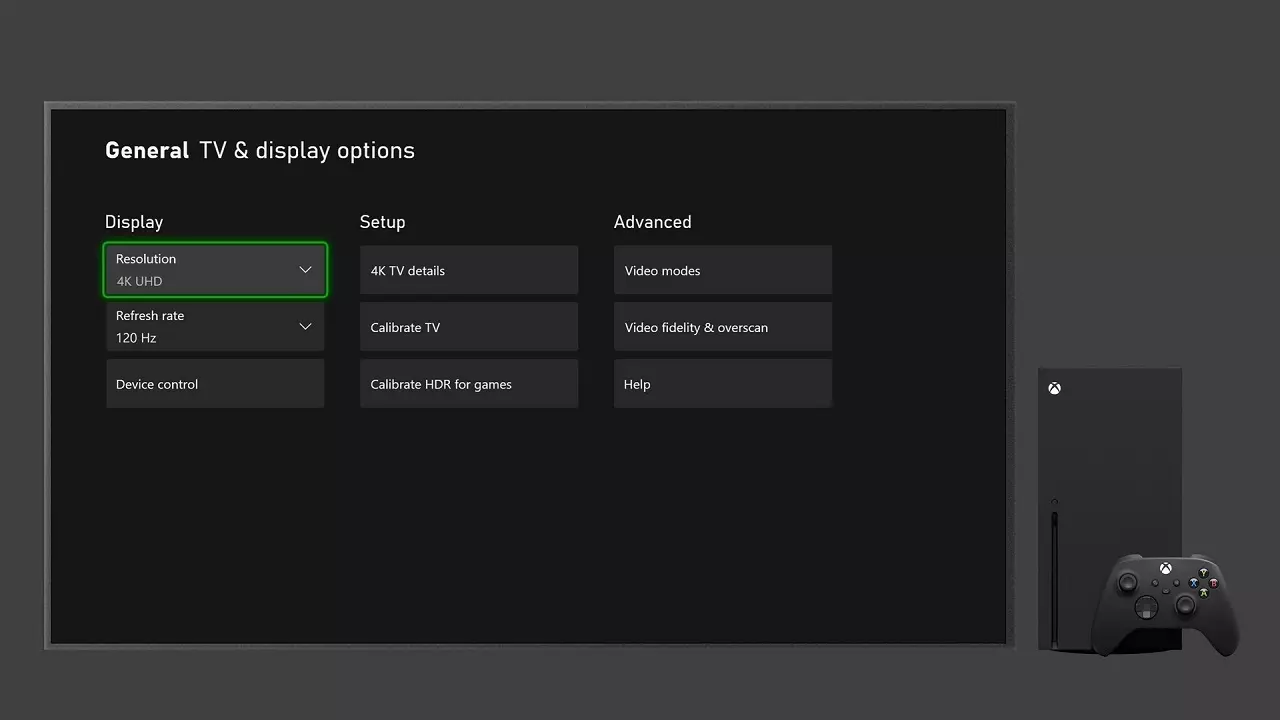

Lato Xbox invece, la vecchia One Fat non è tuttora capace di gestire l’HDR nei videogiochi. Solo Xbox One S e Xbox One X dispongono di questa funzione. Abbiamo ovviamente una guida anche per le piattaforme Microsoft, che include quelle di ultima generazione, Xbox Series X e Xbox Series S.

HDR nei videogiochi per Windows 10 e 11

Su PC l’HDR è arrivato un pochino in ritardo rispetto alle console. È servita l’integrazione con Windows 10 e poi Windows 11. Allo stato attuale però è perfettamente compatibile con questa tecnologia.

Per poter usare l’HDR nei videogiochi PC, dobbiamo prima attivarlo nelle impostazioni video del sistema operativo. Troverete tutte le informazioni nei prossimi paragrafi.

Come attivare l’HDR nei videogiochi

È arrivato il momento di affrontare la parte più difficile della spiegazione, ovvero quella che riguarda i requisiti e le compatibilità dell’HDR nei videogiochi.

Come al solito dobbiamo parlare del guazzabuglio degli standard e delle certificazioni, tutti riconducibili ai display in commercio e al modo in cui gestiscono l’alta gamma dinamica. Tra gli elementi da considerare c’è anche l’interfaccia.

Tuttavia, come detto in apertura, il nostro obiettivo è quello di semplificare i concetti nel miglior modo possibile, evitando volutamente tutte le nozioni più complesse. Andiamo per gradi…

Monitor e TV con HDR

Il display in nostro possesso è un requisito fondamentale. Il vostro monitor o il vostro televisore devono riportare la dicitura HDR nelle specifiche tecniche. Capita che sia indicato con HDR10, diretto riferimento allo standard attualmente più diffuso.

In ultimo dovete controllare di disporre dell’interfaccia giusta. Un cavo HDMI versione 2.0 è più che sufficiente per gestire nel modo giusto l’HDR nei videogiochi, in relazione agli standard audio-video. Se però disponete di un pannello moderno che prevede un ingresso HDMI 2.1, allora è assolutamente conveniente sfruttare questa versione migliorata.

Interfacce più datate possono essere un problema in base alle circostanze. Quindi seppur non vada esclusa la possibilità di attivare l’HDR, conviene farlo su dispositivi dotati delle più recenti tecnologie.

Noi di Videogiochitalia abbiamo anche una guida che vi aiuta a scegliere il miglior televisore da abbinare alle vostre console di nuova generazione, la trovate a questo indirizzo. Abbiamo inoltre un articolo che vi spiega come attivare i 120fps su PlayStation 5, uno per i 120fps su Xbox series X e infine uno per i 120fps su Xbox Series S.

Come attivare l’HDR nei videogiochi su PC

Anche i giocatori PC possono sfruttare lo standard HDR. Per farlo basta disporre di una GPU recente, con interfaccia HDMI 2.0 o Display Port almeno 1.2. Ovviamente anche il monitor deve essere compatibile e vale lo stesso principio dei televisori.

Infine è necessario aggiornare Windows 10 o Windows 11 all’ultimo update per poi attivare l’HDR nelle impostazioni del sistema operativo, alla voce dedicata allo Schermo. Le precedenti versioni del famoso sistema operativo Microsoft non sono compatibili.

Fatte queste dovute premesse possiamo addentrarci nel vasto e complicato mondo degli standard e delle certificazioni.

Gli attuali standard HDR

Come per ogni altra tecnologia, anche nel caso dell’HDR esistono diversi standard con caratteristiche differenti.

Gli standard principali sono HDR10, HDR10+, Dolby Vision e HLG. Vediamo di che si tratta:

- HDR10: è lo standard più diffuso in assoluto. Tutti i pannelli in commercio sono compatibili in quanto si tratta di una soluzione open source. Si basa sullo spazio colore BT.2020 con codifica a 10bit. Il suo limite risiede nei metadati statici.

- HDR10+: è la versione avanzata dell’HDR10. Si tratta sempre di una tecnologia open source e i requisiti sono gli stessi. A cambiare sono i metadati che da statici diventano dinamici. Ad oggi non si è ancora diffuso e non viene supportato dalla maggior parte dei display e delle sorgenti.

- Dolby Vision: standard sviluppato da Dolby Laboratories, basato sempre sullo spazio colore BT.2020 con codifica però a 12 bit. La sua forza risiede nei metadati dinamici mentre la sua debolezza è la licenza d’uso, che ne ha ridotto la diffusione.

- HLG: acronimo di Hybrid Log Gamma. Questo standard è stato sviluppato nello specifico per le trasmissioni televisive. Combina un segnale SDR con uno HDR, per risparmiare sulla banda, ed è compatibile anche con gli schermi SDR.

Standard HDR nei videogiochi

A noi giocatori interessano solo due standard al momento, l’HDR10 e il Dolby Vision. Se volete approfondire le differenze tra queste due soluzioni vi consigliamo di leggere un nostro precedente articolo.

L’HDR nei videogiochi si limita quasi sempre all’HDR10 nella sua versione base, che prevede metadati statici. PlayStation 4, PlayStation 5 e PC Windows non offrono altre compatibilità.

Solo le console Xbox permettono agli utenti di attivare il Dolby Vision anche nei giochi, ma al momento mancano i display capaci di gestirlo nel miglior modo possibile (salvo rari modelli top di gamma ndr).

Se vi interessa una guida per attivare Dolby Vision su Xbox Series X o Series S, vi consigliamo un nostro articolo dedicato.

Differenze e risultati dell’HDR nei videogiochi

Al di là dello standard in uso, che comunque nei videogiochi è quasi sempre e solo HDR10, i risultati possono essere altalenanti, perché vincolati alle specifiche del pannello.

Non dobbiamo sottovalutare ovviamente come il gioco stesso implementi l’alta gamma dinamica, ma parliamo di una tecnologia che per sua natura si lega indissolubilmente al modo in cui viene gestita dal display.

Ogni TV ha le sue specifiche anche a seconda della fascia di prezzo in cui va a piazzarsi e lo stesso accade nel settore dei monitor. Ergo l’HDR nei videogiochi può ottenere risultati completamente diversi in base al pannello in uso e in alcuni casi estremi (magari sui modelli più economici) è anche possibile ottenere una miglior resa in SDR.

Vediamo quindi quali elementi vanno presi in considerazione per sfruttare al meglio l’HDR nei videogiochi.

HDR nei videogiochi e caratteristiche del display

I risultati dell’HDR si legano ad alcuni elementi come il gamut colore, la luminosità massima, la tecnologia in uso e il tone mapping.

Tra tutti questi è proprio il tone mapping a rappresentare la più importante delle criticità, soprattutto sui display di fascia media e bassa.

Tone mapping in HDR: di che si tratta?

Tone mapping, o tradotto mappatura dei toni, è il modo in cui il display adatta i fotogrammi in HDR a quelle che sono le potenzialità del pannello.

Per capirci usiamo un esempio diretto usando i film. Per prima cosa, vi chiediamo di figurare il film come un contenuto, mentre il televisore come il contenitore che dovrà contenerlo. Si tratta di un’allegoria che ci permette di semplificare l’argomento ai minimi termini.

HDR nei film

I film vengono masterizzati in HDR attraverso un processo chiamato grading che detta poi anche le specifiche del contenuto, compresa la luminosità massima.

Un grading a 1000nits implica che quel film avrà come picco massimo in HDR proprio questa luminosità. Tale film però dovrà poi essere visualizzato su televisori con specifiche diverse. Alcuni avranno la capacità di visualizzare immagini sino a 500nits, altri 1000nits, altri ancora 2000nits e così via.

Dobbiamo quindi adattare il contenuto, ovvero il film, alle specifiche del contenitore, ovvero il nostro TV, onde evitare di perdere dettagli visivi importanti. Interviene il processo di tone mapping che ha il compito di evitare la perdita di informazioni.

Quando il nostro televisore inizia il processo di tone mapping, si affida a delle informazioni nascoste, chiamate metadati.

HDR e metadati

I metadati spiegano al nostro televisore come adattare le immagini in ingresso alle sue specifiche e potenzialità.

Per farlo comunicano al nostro display le informazioni relative alla luminosità massima del pixel più luminoso dell’intero contenuto (in gergo tecnico MaxCLL – maximun content light level) e quelle relative alla luminosità media dei pixels per tutti i fotogrammi (MaxFALL – maximun frame average light level).

A questo punto subentra una potenziale differenza a seconda del formato HDR. Come detto in un paragrafo precedente, i metadati possono essere statici (HDR10) oppure dinamici (Dolby Vision, HDR10+).

Metadati statici e metadati dinamici

Per comprendere la differenza tra le due tipologie di metadati, in relazione poi al processo di tone mapping, supponiamo di dover visualizzare un film ambientato interamente di notte e masterizzato in HDR10 con metadati statici. Per esempio su di una spiaggia illuminata solo dalla luce della luna e dal fuoco di un falò.

Ora supponiamo che il master del film preveda un picco di 1000nits, perché nella sequenza del fuoco che brucia almeno un pixel riesce ad arrivare a questa luminosità massima. Mentre la luminosità media del cielo notturno non supera i 100nits.

Noi stiamo guardando questo film su di un televisore che non riesce a superare i 500nits di picco, a causa delle sue specifiche tecniche.

Trattandosi di HDR10 con metadati statici, tutto il contenuto del film, compreso tra 0 e 1000nits, viene compresso nel range visualizzabile dal display, quindi tra 0 e 500nits.

In questo caso il processo di compressione rischia di compromettere la qualità visiva. A fronte di una perdita di informazioni l’immagine risulterà eccessivamente scura, coprendo alcuni dettagli altrimenti visibili.

Un televisore dotato di un buon tone mapping cercherà di compensare questa perdita di informazioni, per non cancellare i dettagli delle zone più scure o per non bruciare il bianco nelle zone più luminose.

Dolby vision e metadati dinamici

Quando invece il nostro film dispone di metadati dinamici, magari perché masterizzato in Dolby Vision, il televisore riceve molte più informazioni.

Questi metadati lo avvisano che solo il fuoco del falò arriva a 1000nits e il display si comporta di conseguenza, senza la perdita di informazioni fondamentali, fotogramma per fotogramma.

Il risultato è un’immagine molto più fedele a quella pensata in origine durante il grading del film.

Videogiochi e tone mapping

L’esempio del film, semplificato davvero ai minimi termini, serve a farvi capire il principio alla base del tone mapping e all’impatto dei metadati.

Tuttavia i videogiochi sono immagini sintetiche che possono comportarsi diversamente. Il tone mapping diventa ancora più importante, perché tutti i dettagli dell’immagine devono poter essere visualizzati dal giocatore, in quanto dovrà interagire con gli elementi dello scenario.

Per capirci: supponiamo di giocare a un simulatore di guida molto impegnativo. Entriamo in una galleria e alla fine del tunnel la luce del sole in HDR brucia i dettagli, impedendoci di vedere il brutto tornante che ci aspetta proprio all’uscita.

Finiremo con lo schiantarci contro il bordo della strada a causa di una perdita di informazioni dell’HDR, che non è riuscito a visualizzare i dettagli relativi alla curva, perché mascherati dalla forte luce del sole. Per aiutare i giocatori con pannelli di fascia medio-bassa, i produttori hardware di console e display si sono messi d’accordo per sviluppare un software di calibrazione, chiamato HGiG.

Come calibrare l’HDR nei videogiochi con HGiG

HGiG è l’acronimo di HDR Gaming Interest Group. A differenza di sigle come HDR10 e Dolby Vision, questa dicitura non indica uno standard, bensì una semplice compatibilità.

Si tratta infatti della compatibilità con un software di calibrazione, che ci permette di ritoccare manualmente i livelli del bianco e del nero dei videogiochi in HDR. Le attuali console in commercio offrono agli utenti questa possibilità attraverso delle applicazioni integrate, ma per poterla usare è necessario che nel televisore sia presente l’opzione specifica per l’HGiG.

Tale opzione si trova quasi sempre nelle impostazioni video del pannello, in un sottomenù dedicato proprio al tone mapping. Una volta attivata sul TV possiamo aprire l’applicazione su console e calibrare l’HDR nei videogiochi manualmente.

Tuttavia i risultati possono variare da gioco a gioco e non sempre conviene utilizzare questo formato HGiG. Quasi sempre è conveniente affidarsi al tone mapping gestito dall’elettronica del display o dalle più precise impostazioni grafiche dei singoli titoli (se presenti).

HDR sui display da gioco

La mappatura dei toni è quindi un elemento fondamentale quando si tratta di videogiochi. Tuttavia sui televisori top di gamma, che possono raggiungere picchi di luminosità molto elevati (anche attorno ai 2000nits ndr), il tone mapping non rappresenta quasi mai un problema.

Discorso diverso per i display di fascia medio bassa, che raramente arrivano ai 1000nits di picco (la media è di 500nits ndr). In questo caso il modo in cui il pannello gestisce i toni può fare una grossa differenza.

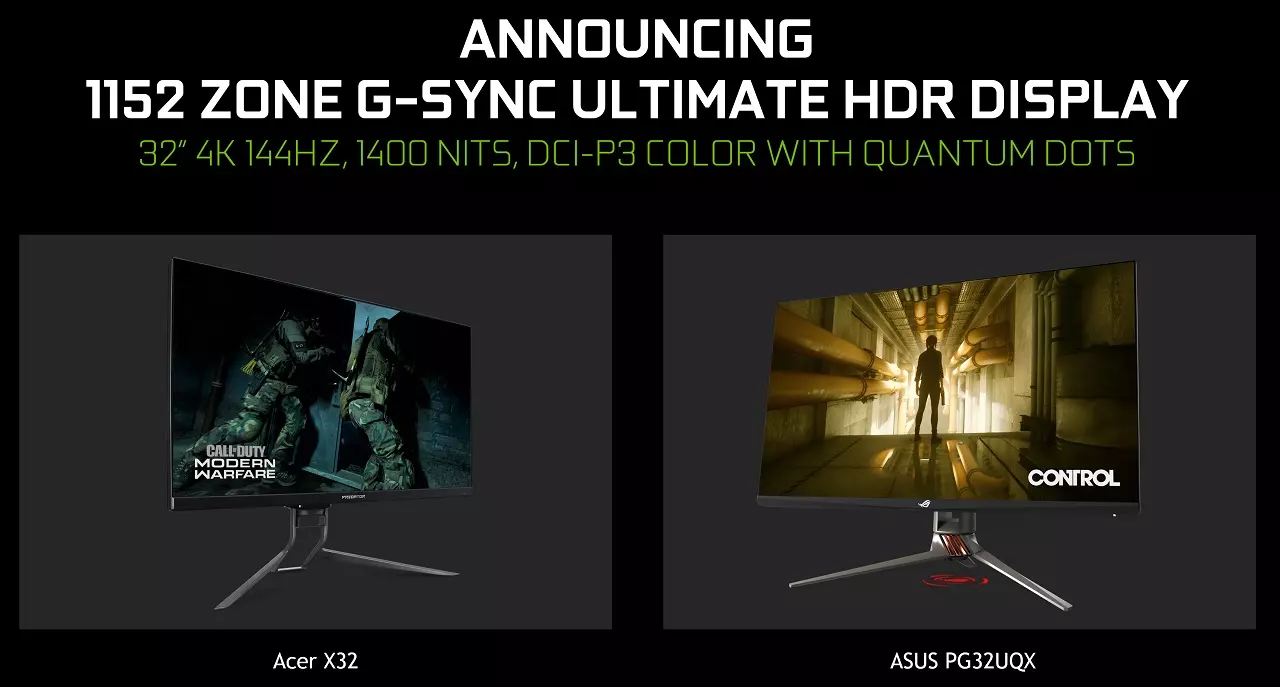

Ancora più complessa è la situazione dei monitor da gaming, dove si è anche cercato di stabilire delle regole di certificazione più elastiche rispetto ai requisiti dei televisori.

HDR nei videogiochi: monitor vs TV

Sia i monitor che i televisori compatibili con l’HDR dovrebbero sottostare a delle regole di certificazioni, capaci di fornire al consumatore le giuste informazioni in fase di acquisto. Tuttavia sono regole piuttosto generiche che non rappresentano una garanzia di qualità.

Per esempio: un display LCD potrebbe essere capace di raggiungere un picco di luminosità a 1000nits per mezzo di una tecnologia chiamata local dimming.

Il dimming accende e spegne i led di retroilluminazione del display, suddividendolo in zone. In questo modo, spegnendo i led solo nelle zone dove l’immagine è più scura, aumenterà il contrasto in potenziale, coprendo di conseguenza un range più ampio.

Tuttavia lo stesso dimming potrebbe essere problematico. A seconda del numero di zone e di pixels coinvolti potrebbero manifestarsi degli artefatti visibili e poco gradevoli, obbligandoci a disattivare questa funzione con una conseguente riduzione della luminosità massima generale.

In altri casi ancora il display potrebbe surriscaldarsi, abbassando la luminosità di picco a sua discrezione onde evitare problemi di natura tecnica. Di conseguenza non è facile orientarsi verso il giusto monitor o il giusto televisore. Sulla fascia medio bassa è sempre questione di compromessi. Solo la fascia più alta di mercato offre garanzia di ottimi risultati.

Inoltre il mercato TV gode di maggiori controlli e una qualità media molto più alta rispetto al settore dei monitor da gaming.

HDR nei monitor da gaming

Il settore dei monitor è molto più vario di quello dei televisori. Copre più standard, più risoluzioni, più refresh-rate, più compatibilità e interfacce.

Tuttavia, in termini di elettronica, non c’è monitor che a parità di prezzo possa eguagliare un televisore, perché sono dispositivi pensati per target differenti.

Per quanto riguarda l’HDR nello specifico, che si lega come visto all’elettronica e alle specifiche molto più degli altri parametri, i monitor sono ancora parecchio indietro.

Per regolamentare la situazione in generale sono subentrate le certificazioni, basate su alcuni requisiti.

Certificazioni HDR per monitor da gaming

L’HDR nei videogiochi ormai è una realtà tanto su console quanto su PC. Era dunque necessario regolamentare anche il settore dei monitor da gaming.

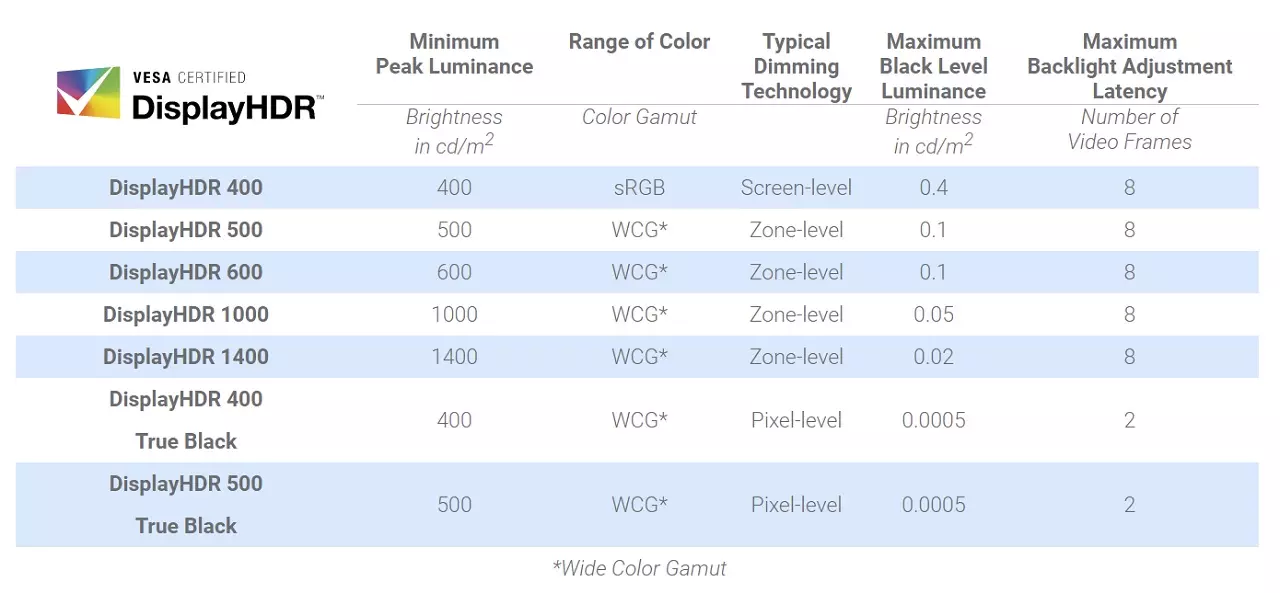

Allo stato attuale abbiamo sei certificazioni primarie, basate sui requisiti dettati da VESA in relazione alla luminosità di picco e al gamut colore dei singoli display.

Si suddividono in: HDR400, HDR500, HDR600, HDR1000, HDR1400 e TrueBlack 400/500/600, quest’ultima specifica per i monitor con tecnologia OLED.

La certificazione non è garanzia di qualità

La certificazione HDR400 è l’entry level commerciale e rappresenta anche quella più diffusa. Si tratta di una approssimativa gestione dell’HDR, spesso combinata a un gamut colore che non supera di molto la copertura di un normale SDR.

In questi casi parlare di HDR è quasi una forzatura, così come nel caso della certificazione HDR500. Per una resa efficace di questa tecnologia conviene partire dalla certificazione HDR600, per poi salire.

Purtroppo sono rari i monitor che riescono a sfoggiare questo risultato e tendono a essere molto costosi. Inoltre, come detto nei paragrafi precedenti, la sola certificazione non basta.

Un display HDR600 o HDR1000 con una pessima gestione dei toni, o magari un pessimo local dimming, potrebbe comunque compromettere la resa dell’HDR nei videogiochi, nonostante le sue specifiche tecniche. Inoltre il mercato è pieno di display privi di certificazione, dove la compatibilità con questa tecnologia viene indicata solo dalla dicitura HDR10 nelle schede tecniche.

Di conseguenza, se volete attivare l’HDR nei videogiochi, l’unico consiglio che possiamo darvi è quello di cercare sempre recensioni mirate dei singoli modelli. Articoli che testano il display in modo specifico, magari valutandone l’effettiva qualità nel campo del gaming su console e su PC.

HDR nei videogiochi: come scegliere il giusto display

Arrivati a questo punto vi sarà chiaro che l’HDR nei videogiochi rappresenta un valore aggiunto solo quando il nostro display è davvero capace di gestirlo nel miglior modo possibile.

Il caos delle certificazioni e delle varie specifiche non aiuta il compratore inesperto. Per questo motivo vi conviene seguire i consigli dei siti specializzati, che a fronte di diversi test mirati scoperchiano le reali capacità dei display, nonché le potenziali problematiche dovute al dimming, alla luminosità o al tone mapping.

Anche noi di Videogiochitalia abbiamo delle guide dedicate ai monitor e ai televisori. Se vi interessa comprare un monitor per sfruttare al meglio le vostre console di ultima generazione, vi consigliamo di leggere i nostri precedenti articoli dedicati a PlayStation 5 e Xbox Series X.

Come attivare l’HDR su PlayStation e Xbox

- Come attivare l’HDR su PS5

- Come attivare l’HDR su PS4

- Come attivare l’HDR su Xbox Series X|S

- Qual è la differenza tra HDR e Dolby Vision

Articoli Correlati

Come attivare l’HDR su Xbox Series X e Xbox Series S

Come attivare l’HDR su Xbox Series X e Xbox Series S Le scorte di Nintendo Switch 2 saranno sufficienti per ostacolare i bagarini? Risponde la società

Le scorte di Nintendo Switch 2 saranno sufficienti per ostacolare i bagarini? Risponde la società Nintendo Switch Lite Hyrule Edition data di uscita, prezzo e preordini

Nintendo Switch Lite Hyrule Edition data di uscita, prezzo e preordini

PC

PC

Come attivare l’HDR su Xbox Series X e Xbox Series S

Come attivare l’HDR su Xbox Series X e Xbox Series S Le scorte di Nintendo Switch 2 saranno sufficienti per ostacolare i bagarini? Risponde la società

Le scorte di Nintendo Switch 2 saranno sufficienti per ostacolare i bagarini? Risponde la società Nintendo Switch Lite Hyrule Edition data di uscita, prezzo e preordini

Nintendo Switch Lite Hyrule Edition data di uscita, prezzo e preordini